В современном мире главной проблемой для многих компаний и исследовательских организаций является обработка и анализ больших данных. Вместе с тем, объемы данных, которые нужно обработать и проанализировать, постоянно растут и уже достигают неимоверных масштабов.

В этом контексте появление и развитие технологий обработки и анализа больших данных становятся неотъемлемой частью работы многих компаний. Одной из самых популярных технологий в этой области является Hadoop.

Hadoop - это открытая платформа, предназначенная для распределенной обработки и анализа больших объемов данных. Ее принцип работы основан на распределении данных на несколько узлов, что позволяет проводить эффективный параллельный анализ информации.

Одна из самых больших проблем при работе с большими данными состоит в ограниченных ресурсах обычных серверов, которые не могут справиться с загрузкой и обработкой больших объемов информации. В таких условиях Hadoop становится незаменимым инструментом, позволяющим преодолеть эти проблемы.

Преимущества использования Hadoop для обработки больших данных

1. Масштабируемость

Hadoop способен обрабатывать и анализировать данные любого объема - от нескольких терабайт до петабайт и даже эксабайт. Благодаря распределенной архитектуре Hadoop позволяет обрабатывать и анализировать данные параллельно на множестве компьютеров, что обеспечивает масштабируемость и повышает производительность.

2. Отказоустойчивость

Hadoop имеет встроенные механизмы отказоустойчивости, которые позволяют обработку и анализ данных продолжать даже при отказе одного или нескольких компьютеров. Дублирование данных и автоматическая перераспределение задач позволяют обеспечить непрерывность работы системы.

3. Экономичность

Hadoop основан на открытом программном обеспечении, что позволяет снизить затраты на лицензии и оборудование. Благодаря использованию комодитизованного оборудования, Hadoop является более экономичным решением для обработки больших данных по сравнению с традиционными коммерческими решениями.

4. Возможность обработки разнообразных данных

Hadoop поддерживает обработку и анализ не только структурированных данных, но и полуструктурированных и неструктурированных данных. Это означает, что Hadoop может работать с данными из различных источников, в том числе с веб-логами, текстовыми документами, медиафайлами и т.д.

5. Поддержка различных инструментов анализа

Hadoop предлагает набор инструментов для анализа данных, таких как Apache Hive, Apache Pig, Apache Spark и другие. Эти инструменты позволяют проводить сложные аналитические операции и строить высокопроизводительные аналитические приложения.

Использование Hadoop для обработки больших данных позволяет компаниям справиться с вызовами цифровой трансформации, обеспечивая эффективность, масштабируемость и гибкость в работе с данными любого объема и типа.

Гибкость и масштабируемость

Гибкость Hadoop заключается в возможности работать с различными типами данных, включая структурированные, полуструктурированные и неструктурированные данные. Она поддерживает разнообразные форматы данных, такие как CSV, JSON, XML и многие другие. Благодаря этому, разработчики могут легко адаптироваться к различным источникам данных и работать с ними без необходимости преобразования данных.

Масштабируемость Hadoop позволяет обрабатывать большие объемы данных, распределенно распределяя их на несколько узлов в кластере. Кластер состоит из нескольких компьютеров, называемых узлами, которые работают совместно для обработки и анализа данных. При необходимости можно добавлять дополнительные узлы, чтобы увеличить мощность обработки данных. Это позволяет Hadoop эффективно масштабироваться и обрабатывать даже самые большие объемы данных.

Hadoop также предоставляет гибкость для создания различных типов задач обработки данных с помощью MapReduce – парадигмы, позволяющей разделять данные на небольшие части и выполнять распределенные вычисления над ними. MapReduce обеспечивает параллельную обработку данных и позволяет разработчикам создавать сложные алгоритмы обработки данных, подходящие для их конкретных потребностей.

Таким образом, гибкость и масштабируемость Hadoop делают его мощным инструментом для обработки и анализа больших данных, позволяя эффективно работать с разнообразными типами данных и обрабатывать даже самые большие объемы информации.

Эффективность обработки данных

Hadoop обеспечивает высокую степень параллелизма, распределяя задачи по кластеру узлов. Это позволяет обрабатывать большие объемы данных быстрее и эффективнее, сокращая время выполнения задач.

Одно из преимуществ использования Hadoop для обработки данных - это масштабируемость. Hadoop легко масштабируется горизонтально, добавляя новые узлы к кластеру. Это позволяет обрабатывать все большие объемы данных без потери производительности.

Наличие репликации данных в Hadoop также способствует эффективности обработки данных. Репликация данных позволяет распределить данные по нескольким узлам, что увеличивает отказоустойчивость системы и уменьшает время доступа к данным.

Кроме того, Hadoop предоставляет мощные инструменты для агрегации и анализа данных. Благодаря MapReduce, Hadoop позволяет эффективно обрабатывать данные на разных уровнях сложности, от простых статистических вычислений до сложных алгоритмов машинного обучения.

Отказоустойчивость и надежность

Если один из узлов кластера выходит из строя или происходит сбой, Hadoop способен автоматически перенаправить задания на другие доступные узлы, обеспечивая непрерывную работу системы и минимизацию времени простоя.

Дополнительно, Hadoop имеет механизм репликации данных, который позволяет создавать несколько копий данных на разных узлах кластера. Это делает систему устойчивой к потере данных и обеспечивает их сохранность в случае сбоев или ошибок.

Более того, Hadoop имеет встроенный механизм проверки целостности данных, который позволяет обнаруживать и исправлять ошибки в данных во время их чтения и записи. Это гарантирует надежность и точность результатов анализа.

Таким образом, Hadoop обеспечивает высокую отказоустойчивость и надежность при обработке и анализе больших данных, что делает его предпочтительным выбором в условиях современной индустрии и бизнеса.

Распределенная обработка данных

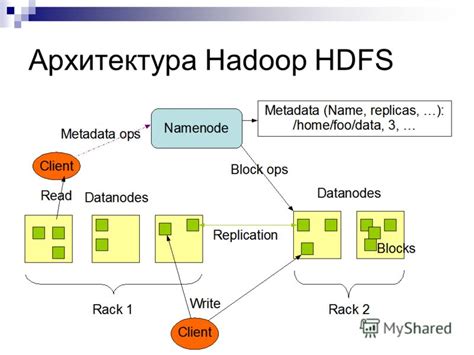

В сети кластеров Hadoop каждый компьютер выполняет роль узла данных (Data Node) или узла имени (Name Node). Узлы данных хранят и обрабатывают данные, а узлы имени являются центральным узлом, отслеживающим распределение данных и контролирующим выполнение задач. Такая архитектура позволяет системе быть масштабируемой и устойчивой к отказам.

Распределенная обработка данных в Hadoop основана на принципе "разделяй и властвуй". Данные разбиваются на блоки определенного размера и распределяются по узлам данных. Затем каждый узел данных обрабатывает свой блок данных независимо от других узлов, что позволяет параллельно выполнять задачи и ускоряет общую обработку данных. Результаты обработки объединяются и передаются обратно узлу имени.

Технология распределенной обработки данных в Hadoop является открытой и гибкой. Ее можно использовать для самых разнообразных задач, таких как анализ больших объемов данных, построение рекомендаций, выявление аномалий и многое другое. Благодаря распределенной обработке данных Hadoop позволяет эффективно работать с большими объемами информации и обеспечивает высокую производительность и отказоустойчивость системы.

Широкий набор инструментов

Hadoop предоставляет широкий набор инструментов, которые позволяют обработать и проанализировать большие объемы данных. Он предоставляет гибкую и мощную платформу, которая позволяет эффективно распределить и обрабатывать данные на кластере серверов.

Одним из ключевых инструментов Hadoop является Hadoop Distributed File System (HDFS). HDFS разбивает большие файлы на части и распределяет их по разным узлам кластера, что позволяет обрабатывать данные параллельно. Это улучшает производительность и отказоустойчивость системы.

Для обработки данных Hadoop использует специальную программную модель, называемую MapReduce. Она позволяет распределить задачи на обработку данных между узлами кластера и собрать результаты выполнения задач. MapReduce обеспечивает масштабируемость и надежность при обработке больших объемов данных.

Hadoop также предоставляет набор инструментов для работы с данными, включая Hive, Pig и HBase. Hive позволяет использовать язык SQL для запросов к данным в Hadoop. Pig предоставляет высокоуровневый язык программирования для обработки данных. HBase является распределенной базой данных, которая предоставляет возможность эффективного хранения и обработки структурированных данных.

Кроме того, Hadoop поддерживает множество других инструментов и платформ, которые позволяют анализировать и визуализировать данные, строить предсказательные модели и выполнять другие задачи обработки и анализа данных. Это делает Hadoop мощной и универсальной платформой для работы с большими данными.

| Преимущества | Недостатки |

| Масштабируемость | Сложность установки и настройки |

| Отказоустойчивость | Необходимость обучения и знания специфических инструментов |

| Гибкость и мощность | Высокая стоимость оборудования |

Удобство использования и интеграция

Hadoop предоставляет удобный интерфейс командной строки, который позволяет разработчикам легко управлять и анализировать данные. Благодаря этому интерфейсу, можно легко запускать и контролировать задачи обработки данных, а также мониторить процесс выполнения.

Важно отметить, что Hadoop также хорошо интегрируется со многими популярными инструментами и программами для обработки данных. Например, с помощью Hadoop можно легко интегрировать с системами, такими как Apache Hive и Apache Pig, которые предоставляют удобный и выразительный язык для работы с данными.

Кроме того, Hadoop также поддерживает интеграцию с другими системами и инструментами для обработки больших данных, такими как Apache Spark и Apache Storm. Благодаря этой интеграции, разработчики получают возможность использовать Hadoop вместе с другими мощными инструментами, что значительно расширяет возможности анализа и обработки данных.

В целом, благодаря своему удобству использования и возможности интеграции с другими инструментами, Hadoop является одним из наиболее популярных инструментов для обработки и анализа больших данных.