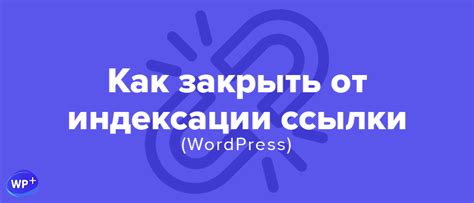

Фильтр индексации – это важный инструмент для оптимизации и продвижения вашего сайта. Он позволяет контролировать то, какие страницы вашего сайта будут индексироваться поисковыми системами, а какие – нет. Таким образом, вы можете управлять тем, как ваш сайт отображается в результатах поиска, и улучшить позиции в выдаче.

В этой статье мы рассмотрим лучшие способы настройки фильтра индексации и дадим вам подробную инструкцию, как это сделать. Мы расскажем о значении тегов noindex и nofollow, а также поделимся советами по использованию файла robots.txt для управления индексацией страниц.

Настройка фильтра индексации поможет вам избежать дублирования контента, которое плохо сказывается на ранжировании вашего сайта, а также избежать индексации нежелательных страниц, таких как страницы с повторяющимся контентом, временные страницы или тестовые страницы.

Понимание фильтрации индексации

Одна из основных причин, почему фильтрация индексации является важной, заключается в возможности исключения из поисковой выдачи страницы с дублирующимся контентом или страницы с низкой релевантностью для пользовательского запроса. Например, веб-мастеры могут захотеть исключить из поиска страницы с конфиденциальной информацией или временные страницы, которые не предназначены для показа в поисковой выдаче.

Существует несколько методов управления фильтрацией индексации. Один из самых распространенных способов - использование файла robots.txt, который позволяет веб-мастеру указать поисковым системам, какие страницы следует индексировать, а какие - нет.

Другой популярный метод - использование мета-тегов "noindex" и "nofollow". Мета-тег "noindex" указывает поисковым системам, что страницы не должны быть индексированы, а мета-тег "nofollow" указывает, что ссылки на странице не должны следовать.

Также, веб-мастеры могут использовать инструменты поисковых систем или плагины, чтобы установить более специфичные правила фильтрации индексации. Например, они могут настроить правила для блокировки определенных категорий страниц или определенных типов контента.

Кроме того, важно следить за отчетами об индексации и применять соответствующие корректировки для улучшения фильтрации. Например, если поисковая система все еще индексирует страницы, которые должны быть заблокированы, необходимо убедиться, что файл robots.txt или мета-теги настроены правильно и нет ошибок.

В целом, понимание эффективной фильтрации индексации является ключевым аспектом успешной оптимизации поисковой видимости сайта. При правильной настройке и использовании методов фильтрации, веб-мастеры смогут более точно контролировать, какие страницы попадают в поисковую выдачу и повышать свою конкурентоспособность в поисковых системах.

Важность правильной настройки фильтра

Правильная настройка фильтра индексации позволяет контролировать и ограничивать доступ поисковых роботов к определенным страницам или разделам сайта. Это особенно актуально в случае, когда у вас есть контент, который вы не хотите индексировать (например, дубликаты страниц или страницы с чувствительной информацией). Благодаря правильной настройке фильтра, вы сможете исключить такие страницы из индекса, что позволит избежать проблем с дублированным контентом и сохранить конфиденциальность данных.

Кроме того, правильная настройка фильтра индексации позволяет улучшить скорость индексации сайта поисковыми системами, так как поисковые роботы будут обращаться только к тем страницам, которые действительно важны и нужны для пользователя. При этом, не нужно забывать об оптимизации метатегов и релевантности контента, которые также влияют на скорость индексации и позиционирование сайта в поисковой выдаче.

Лучшие способы настроить фильтр индексации

Вот несколько лучших способов настроить фильтр индексации:

| Способ | Описание |

|---|---|

| 1 | Использование robots.txt |

| 2 | Установка мета-тега noindex |

| 3 | Использование директивы X-Robots-Tag |

| 4 | Инструкция для поисковых роботов |

Использование robots.txt – это самый простой и распространенный способ ограничить доступ поисковых роботов к определенным страницам вашего сайта. Вы можете указать путь к файлам или целые директории, которые не должны индексироваться.

Установка мета-тега noindex на странице позволяет указать поисковым системам, что данная страница не должна быть индексирована. Это особенно полезно, если у вас есть страницы с дублирующимся или устаревшим контентом, которые не нужно отображать в поисковой выдаче.

Директива X-Robots-Tag позволяет управлять индексацией страницы непосредственно через файл сервера, без необходимости добавления мета-тегов на каждую отдельную страницу. Вы можете установить различные значения для директивы, указывающие поисковым роботам, как обрабатывать страницу.

Наконец, вы можете создать специальную инструкцию для поисковых роботов в файле robots.txt или мета-теге, указав дополнительные параметры для индексации, например, частоту обновления страниц или приоритеты.

Выбрав один или несколько из этих способов, вы сможете более точно настроить фильтр индексации и улучшить показатели вашего сайта в поисковой выдаче.

Инструкция по настройке фильтра индексации

1. Определите свои индексируемые страницы

Прежде чем приступать к настройке фильтра индексации, важно определить, какие страницы вашего сайта должны быть проиндексированы поисковыми системами. Проведите анализ содержимого и структуры сайта и выделите основные страницы, которые вы хотите видеть в поисковой выдаче. Это поможет вам определить дальнейшие настройки фильтра.

2. Используйте мета-теги "noindex" и "nofollow"

Один из самых популярных способов настройки фильтра индексации – использование мета-тегов "noindex" и "nofollow". Мета-тег "noindex" указывает поисковым системам, что данная страница не должна быть проиндексирована, а мета-тег "nofollow" – что страница не должна быть проиндексирована и все ссылки на ней не должны учитываться. Это особенно полезно, если у вас есть страницы с дублирующимся контентом или внутренние страницы, которые вы не хотите видеть в поисковой выдаче.

3. Используйте robots.txt

Файл robots.txt – это текстовый файл, который позволяет вам контролировать индексацию вашего сайта. С помощью этого файла вы можете указать поисковым системам, какие страницы вашего сайта они могут индексировать, а какие – нет. Создайте файл robots.txt в корне вашего сайта и определите нужные настройки для фильтра индексации.

4. Используйте канонические ссылки

Канонические ссылки – это специальные теги, которые указывают на основную (каноническую) страницу из множества дублирующихся страниц. Это позволяет поисковым системам правильно понять, какую страницу следует индексировать и выдавать в результатах поиска. Используйте канонические ссылки для предотвращения индексации дублирующегося контента и улучшения SEO-оптимизации вашего сайта.

5. Проверяйте результаты

После того, как вы настроили фильтр индексации, важно регулярно проверять результаты в поисковых системах. Убедитесь, что только нужные страницы вашего сайта проиндексированы, а нежелательные страницы исключены из поисковой выдачи. Если замечаете ошибки или неправильную индексацию, внесите соответствующие корректировки в фильтр.

Будучи аккуратными и последовательными в настройке фильтра индексации, вы сможете оптимизировать индексацию вашего сайта и повысить его видимость в поисковых системах.

Проверка и поддержка работы фильтра

После настройки фильтра индексации важно регулярно проверять его работу и обеспечивать его надежную поддержку. В этом разделе рассмотрим несколько лучших способов проверки фильтра и оказания ему поддержки.

1. Проверка индексации страниц

Для того чтобы убедиться, что фильтр индексации работает правильно, необходимо проверить индексацию страниц вашего сайта. Воспользуйтесь инструментами поисковых систем, такими как Google Search Console или Яндекс.Вебмастер, чтобы узнать, какие страницы были проиндексированы.

2. Мониторинг поискового трафика

Еще один способ проверки работы фильтра - мониторинг поискового трафика. Если фильтр индексации правильно настроен, вы должны видеть рост органического трафика, согласованного с вашими усилиями по оптимизации и продвижению.

3. Обновление файлов robots.txt и sitemap.xml

Регулярно обновляйте файлы robots.txt и sitemap.xml, в которых указываются инструкции для поисковых роботов. Убедитесь, что все необходимые страницы вашего сайта указаны в sitemap.xml, а нежелательные страницы или директории блокируются в robots.txt.

4. Использование инструментов для анализа ботов

Существуют специальные инструменты для анализа ботов, которые помогут вам проконтролировать индексацию вашего сайта и выявить возможные проблемы. Некоторые популярные инструменты включают Screaming Frog, DeepCrawl и SEMrush.

5. Контроль изменений веб-сайта

Внесение любых изменений на ваш веб-сайт может повлечь за собой изменение индексации страниц. Поэтому следите за любыми изменениями на сайте и проводите тестирование, чтобы убедиться, что фильтр индексации продолжает работать эффективно.

| Преимущества проверки и поддержки фильтра индексации: |

|---|

| - Обеспечение высокой видимости в поисковых системах |

| - Сокращение риска индексации нежелательных страниц |

| - Оптимизация структуры сайта для поисковых роботов |

| - Улучшение пользовательского опыта и конверсий |

| - Повышение эффективности SEO-стратегии |