Файлы robots.txt и sitemap.xml являются важными инструментами для оптимизации работы вашего веб-сайта и повышения его видимости в поисковых системах. Присутствие ошибок в этих файлах может привести к проблемам индексации страниц вашего сайта поисковыми роботами.

Ошибки в файле robots.txt могут препятствовать поисковым роботам в доступе к определенным страницам или разделам вашего сайта, что может привести к неправильной индексации или исключению этих страниц из поисковых результатов.

Ошибки в файле sitemap.xml могут помешать поисковым роботам эффективно индексировать и обновлять содержимое вашего сайта, что также может снизить его видимость и поисковую выдачу.

В данной статье мы рассмотрим некоторые распространенные ошибки в файлах robots.txt и sitemap.xml и предоставим вам полезные инструкции о том, как их исправить и оптимизировать работу вашего веб-сайта для поисковых систем.

Роботы и карта сайта

Файл robots.txt можно использовать для запрета индексации определенных разделов сайта, например, временных или тестовых страниц, а также для указания путей к файлам sitemap.xml. В файле robots.txt вы можете использовать такие команды, как "Disallow" и "Allow", чтобы установить правила для роботов. Подобные правила помогают исключить из индексации страницы, которые вам не нужны или с которыми могут быть проблемы.

Карта сайта имеет XML-формат и содержит ссылки на все доступные страницы вашего сайта. Она помогает поисковым роботам быстро найти все страницы и разделы сайта, что упрощает ее индексацию. При создании XML-карты сайта вы должны указать информацию о приоритете каждой страницы и частоте ее обновления. Существуют специальные инструменты и онлайн-сервисы, которые позволяют сгенерировать карту сайта автоматически, упрощая этот процесс для веб-мастеров.

Совместное использование файла robots.txt и карты сайта (sitemap.xml) обеспечивает более эффективную работу поисковых систем на вашем сайте. Правильная настройка этих файлов может повысить индексацию страниц вашего сайта и повысить ранг в поисковой выдаче, что в свою очередь улучшит видимость и посещаемость вашего сайта.

Шаблон файла robots.txt

Пример стандартного файла robots.txt выглядит следующим образом:

User-agent: * Disallow: /private/ Disallow: /tmp/ Disallow: /cgi-bin/ Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: http://example.com/sitemap.xml

В данном примере:

- User-agent: * - это указание для всех типов роботов;

- Disallow: /private/ - запрещает индексацию страниц, находящихся в каталоге /private/;

- Disallow: /tmp/ - запрещает индексацию страниц, находящихся в каталоге /tmp/;

- Disallow: /cgi-bin/ - запрещает индексацию страниц, находящихся в каталоге /cgi-bin/;

- Disallow: /wp-admin/ - запрещает индексацию страниц, находящихся в каталоге /wp-admin/;

- Allow: /wp-admin/admin-ajax.php - разрешает индексацию конкретной страницы /wp-admin/admin-ajax.php;

- Sitemap: http://example.com/sitemap.xml - указывает путь к файлу sitemap.xml, который содержит информацию о структуре сайта.

Важно отметить, что для каждого сайта шаблон может варьироваться в зависимости от его структуры и целей, а также от требований различных поисковых систем.

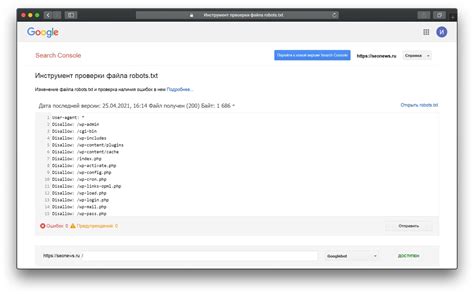

Ошибки в файле robots.txt

Ошибки в файле robots.txt могут возникать по разным причинам. Например, это могут быть опечатки в синтаксисе или некорректные указания относительного пути к файлам или директориям. Также частой ошибкой является блокировка необходимых для индексации страниц.

Для исправления ошибок в файле robots.txt следует уделить внимание следующим аспектам:

- Проверьте наличие файла robots.txt. Убедитесь, что ваш сайт содержит файл robots.txt и он доступен для чтения поисковым роботам. Для этого в адресной строке браузера введите адрес вашего сайта, добавьте /robots.txt и нажмите Enter. Если вы видите содержимое файла, значит, файл существует и доступен. В противном случае, создайте файл robots.txt и разместите его в корневой директории вашего сайта.

- Проверьте синтаксис файла robots.txt. Для того чтобы файл был корректным, он должен соответствовать протоколу robots.txt. Убедитесь, что каждая команда располагается на новой строке, команды разделяются символом слэш (/) и указание директории или файла заключается в двойные кавычки. При возникновении синтаксических ошибок выполняться может непредусмотренное поведение поисковых роботов.

- Проверьте правильность указания путей. При указании относительных путей в файле robots.txt убедитесь, что они корректны и соответствуют реальной структуре вашего сайта. Ошибочное указание пути может привести к блокировке нужных для индексации файлов или, наоборот, позволить индексировать нежелательные материалы.

- Проверьте разрешения для файлов и директорий. Удостоверьтесь, что файлы, указанные в файле robots.txt, доступны для чтения поисковым роботам. Если файлы закрыты для чтения или имеют неправильные разрешения, поисковые роботы не смогут проиндексировать их. Кроме того, проверьте, что недоступные для индексации директории блокируются, а не доступны для просмотра.

- Проверьте правила блокировки. В отдельных случаях ошибки в файле robots.txt могут возникать из-за неправильно заданных правил блокировки. Проверьте, что вы не блокируете страницы, которые должны быть проиндексированы, и в то же время не разрешаете доступ к нежелательному контенту. Корректное настроенные правила блокировки помогут поисковикам индексировать нужные для них страницы и исключать нежелательные материалы из поисковой выдачи.

При обнаружении ошибок в файле robots.txt рекомендуется исправить их как можно скорее, чтобы предотвратить негативное влияние на индексацию и видимость вашего сайта в поисковых системах.

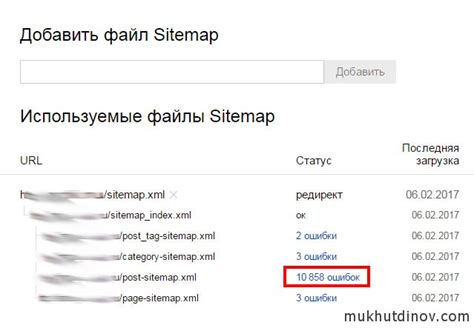

Ошибки в файле sitemap.xml

Вот некоторые распространенные ошибки, которые могут быть найдены в файле sitemap.xml:

| Ошибка | Пояснение | Решение |

|---|---|---|

| Неверный формат URL | URL в файле sitemap.xml должен быть в правильном формате. Например, он должен начинаться с протокола (http:// или https://). | Убедитесь, что все URL в файле sitemap.xml указаны в правильном формате. |

| Неразрешенный URL | Если ваш сайт требует авторизацию или доступ ограничен, поисковые системы не смогут обнаружить и проиндексировать эти страницы. | Исключите ограниченные URL из файла sitemap.xml или предоставьте поисковым системам доступ к ним. |

| Несуществующий URL | Если URL в файле sitemap.xml не существует, поисковые системы не смогут найти страницу для индексации. | Убедитесь, что все URL в файле sitemap.xml являются действительными и доступными для индексации. |

| Дублированные URL | Если один и тот же URL указан в файле sitemap.xml несколько раз, это может смутить поисковые системы и нарушить индексацию. | Удалите дублирующиеся URL из файла sitemap.xml или используйте канонические метки, чтобы указать предпочтительный URL. |

Чтобы исправить ошибки в файле sitemap.xml, рекомендуется использовать инструменты для проверки валидности файлов sitemap, предоставляемые поисковыми системами. Также важно периодически проверять файл sitemap.xml на наличие новых ошибок и обновлять его в соответствии с изменениями на вашем сайте.